Синтаксис информационна мярка

Фиг. 1.1. информационни мерки

Синтаксис мярка работи количеството данни и количеството информация, Ia. изразена по отношение на ентропия (концепцията на несигурност на системата).

Семантичната мярка работи количеството информация, изразена по отношение на обема и степента на включване.

Прагматичен мярка определя от неговата полезност, изразена чрез съответните икономически ефекти.

Синтаксис информационна мярка

Тази мярка на количеството информация, работи с не-лична информация, не се изразяват семантични отношения към обекта.

Днес, най-известни следните методи за количествена информация за измерване: обем, ентропията, алгоритмична.

Том е най-прост и суров начин за измерване на информация. Съответната информация количествено естествено нарича информация обем.

Размерът на информация - това е броя на символите в съобщението. От същия брой може да бъде написана по много различни начини, т.е. с помощта на различни азбуки като двадесет и една - .. 21- XXI- 11001, този метод е чувствителен към формата на представяне (запис) съобщения. При изчисляването на всички, обработвани и съхранявани информация независимо от неговия характер (номера, текстови, изобразяване), представени в двоична форма (с помощта на азбуката се състои от само два символа "0" и "1").

В двоична бройна единица - малко (малко - двоична цифра - малко).

В теорията на информацията, бита - количеството информация, необходима да се направи разграничение между две еднакво вероятни съобщения; и изчислителна малко нарича най-ниската "част" на необходимата памет за съхранение на един от двамата герои "0" и "1" се използва за представяне на данни и intraengine команди. Това е твърде малка единица за измерване, често използвани в практиката големи единици - байта - която е равна на 8 бита, необходими за кодиране на всеки от 256 знака на азбука клавиатура на компютъра (256 = 2 8).

Също така широко използвани още по-големи единици информация, извлечена:

1 килобайт (KB) = 1024 байта = 2 10 байта;

1 мегабайт (MB) = 1024 = 2 Kbytes 20 байта;

1 Gigabyte (GB) = 1024 MB = 2 30 байта.

Наскоро, поради увеличаването на обема на обработена информация, включени в използването на производни на следните единици:

1 терабайта (TB) GB = 1024 = 2 40 байта;

1 петабайт (РВ) TB = 1024 = 2 50 байта.

В редица система единица знак - ди (знак).

Съобщение в двоичен система под формата на осем битов двоичен код 1011 1011 има обем данни Vd = 8 бита.

Съобщение в десетичната система под формата на шест-битов номер 275903 има обем бита Vd = 6 данни.

В теорията на информацията, ентропия и кодиране на стоките, приета подход за измерване на медии. Получаване на информация за всяка система, то винаги е свързано със степента на невежи-ност от страна на получателя за състоянието на системата. Този метод на измерване се основава на следния модел.

Да предположим, че преди информацията за потребителя има някаква предварителна (априори) информация за системата # 945;. След получаване на съобщението за получател б придобита допълнителна информация I (б), намаляване на неговото невежество. Тази информация обикновено е ненадеждна и изразява вероятността, с която го очаква това или онова събитие. Една обща мярка на несигурност (ентропията) се характеризира с комбинация от математически зависимост от тези вероятности. Размерът на информация в съобщението, се определя от това как тази мярка ще намалее след получаване на съобщението.

По този начин, на американския инженер Р. Хартли (1928), процесът на получаване на информация се отнася до избора на един от крайните пунктове зададен предварително набор от N еднакво вероятни съобщения, както и количеството на информацията, аз, която се съдържа в избраното съобщение, определя как двоичен логаритъм на N (Hartley формула):

.

Да предположим, че имате нужда да се отгатне броя на един от набор от числа 1-100. Според формулата на Хартли може да се изчисли колко информация се изисква :. т. е. съобщение съдържа правилно предполагам, броят на информация от приблизително 6,644 единици информация.

Други примери на еднакво Публикации:

1) за хвърляне на монета "спадна опашки" "паднаха Eagle";

2) на страницата на книгата "четен брой на писма", "нечетен брой букви."

Невъзможно е да се отговори еднозначно на въпроса дали постовете са еднакво вероятни "първи излезе от вратите на сградата жената" и "първият, който излезе от вратите на сградата един мъж." Всичко зависи от това какъв вид изграждането му е под въпрос. Ако е така, например, метростанция, вероятността от първите, които се измъкнем от врати е еднаква за мъжете и жените, и ако това е казарма, за мъже, тази вероятност е много по-висок, отколкото при жените.

За целите на този вид американски учен Клод Shennon предложен през 1948 г. различна формула за определяне на количеството информация, която се взема предвид евентуалното неравно вероятността за съобщения в комплект (Шанън формула):

,

където - вероятността, че това е най-тото съобщението се разпределят към набора от N съобщения.

Лесно е да се види, че ако вероятността ... са равни, а след това всеки един от тях е равно на формулата Шанън, и се превръща в формула Хартли.

Освен двете разгледани подходите за определяне на размера на информация, има и други. Важно е да се помни, че всички теоретични резултати са приложими само за определен кръг от случаи, описани първоначалните предположения.

В алгоритмичен теорията на информацията (теорията на раздел алгоритми) предлага алгоритмичен метод за оценка на информацията в съобщението. Всеки пост може да се дължи на количествен характеристика на отражателната програма сложност (размер), което позволява да се произвеждат.

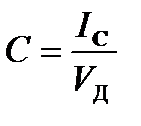

Коефициент информативност (стегнатост) съобщение (степен) се определя чрез съотношението на общия обем информация на данните:

С увеличаване Y намалено количество на работа на преобразуването на информация (данни) в система. Следователно, трябва да се стремим да подобряваме съдържанието на информацията, която разработи специални методи за оптимално кодиране на информацията.

1.4.2.2 Семантичната информационна мярка

Семантика - наука за смисъла, съдържанието на информацията.

За да се измери количеството на семантична информация се използва понятието "потребител речник" т. Е. Съвкупността на разположение на потребителя или системата информация.

Фиг. 2. 1. Определяне на броя на семантична информация възприемат от потребителя, от своя речник IC = F (SP)

Да вземем два крайни случаи, когато броят на IC семантична информация е 0:

- ако потребителят не приема, не разбира постъпващата информация;

- ако потребителят знае, и на информацията, получена не му допадна.

Максималният брой на семантичните покупки информация на потребителите при координирането на семантична неговото съдържание S с вашия речник (), когато получената информация е разбираемо за потребителя и носи го по-рано неизвестен (липсва в неговия речник) информация.

Ето защо, в размер на семантична информация и нови знания в съобщението, получено от страна на потребителя е относителна величина.

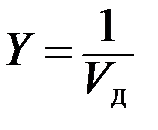

Относителната мярка за количеството на семантична информация може да бъде смисленост коефициент С, определена като съотношението на количеството на семантична информация за обема си: